La computadora es definitivamente uno de los mayores inventos de la historia, la opera prima de la informática, y ese producto que ya no nos podemos imaginar vivir sin. Pero aunque hoy son indispensables para el día a día, fue necesario un largo proceso científico para que apareciera la primera computadora; donde jugaron un papel fundamental la matemática, la ingeniería y el diseño.

¿Sabías que Philippe Dreyfus acuñó la palabra "informática" en 1962 a partir de un neologismo del francés entre las palabras "información" y "automática"? Pero deberemos viajar mucho más atrás en el tiempo para descubrir los orígenes de esta disciplina. Desde la matemática algorítmica antigua, pasando por la comercialización de la primera computadora en 1951 -el ENIAC-, el lanzamiento de la primera Personal Computer de IBM en 1981 y hasta la aparición de tecnologías como la realidad virtual.

¿Cómo llegamos hasta este momento?

Estamos viviendo la Era Digital, y a veces en el torbellino de nuevos inventos nos olvidamos de la historia que hay por detrás, los cimientos que edificaron este momento. Roma no se construyó en un día. En este artículo vamos a ver un repaso de la historia de la informática y las figuras que la hicieron posible.

La historia de las computadoras

Parte 1: Algoritmos, los orígenes de la historia de las computadoras

Quien diría que para un invento tan moderno, haya que volver tan atrás en el tiempo, hasta el siglo IX. Podemos descubrir los pilares de la programación en un científico árabe, Abu Y?ffar al-Jw?riz, conocido como el padre de los algoritmos por sus avances en matemática y lógica. Fueron los teoremas de Al-Jw?rizm? la base necesaria para el desarrollo informático.

Un algoritmo es una serie de instrucciones definidas para resolver un problema o un cálculo. Esto es fundamental para la informática, ya que su objetivo final es crear una máquina rápida y precisa que solucione una serie de problemas.

¿Por qué es importante? Si conocés cómo se compone una computadora sabrías que funcionan a partir de esa serie de algoritmos que le dicen qué hacer dependiendo de qué necesita el usuario.

El próximo gran paso lo dio Leibniz cuando postuló el cálculo binario en 1697.

Una de las figuras más importantes dentro de la informática es Ada Lovelace, matemática del siglo XIX y una de las primeras personas en ver el potencial que tenía la máquina analítica de Charles Babbage, la primera computadora. Mientras Babbage y otros solo la veían como una forma de procesar números, Lovelace fue una visionaria que imaginó una relación mucho más íntima entre hombre y máquina.

Lovelace publicó entre 1842 y 1843 sus "notas", en las que se encuentra el primer programa para una computadora, es decir, el algoritmo que el dispositivo debía ejecutar.

Por su parte, Charles Babbage es considerado el abuelo de las computadoras. Él nunca vio finalizado su invento, ya que la Corona británica retiró su apoyo financiero debido a la larga duración de la investigación. Pero gracias a sus planos su hijo pudo terminarla.

Su máquina se encuentra en el Museo de la Ciencia de Londres, y aunque parezca increíble, todavía funciona

Parte 2: Desde la mecanización de los cálculos hasta el software

La humanidad creó primero herramientas, y luego máquinas, es decir, objetos que usan una fuerza diferente a la suya y que pueden realizar de manera autónoma ciertas operaciones.

Pero había un problema: estos dispositivos mecánicos no eran capaces de modificarse a sí mismos y adaptar el algoritmo para cada problema. ¿Cómo llegamos entonces a las computadoras de hoy?

Alan Turing es considerado el padre de la ciencia computacional teórica y la inteligencia artificial. Su trabajo formalizó los conceptos de algoritmo y computación, y la "máquina Turing" es uno de los primeros modelos de computadoras de propósitos generales.

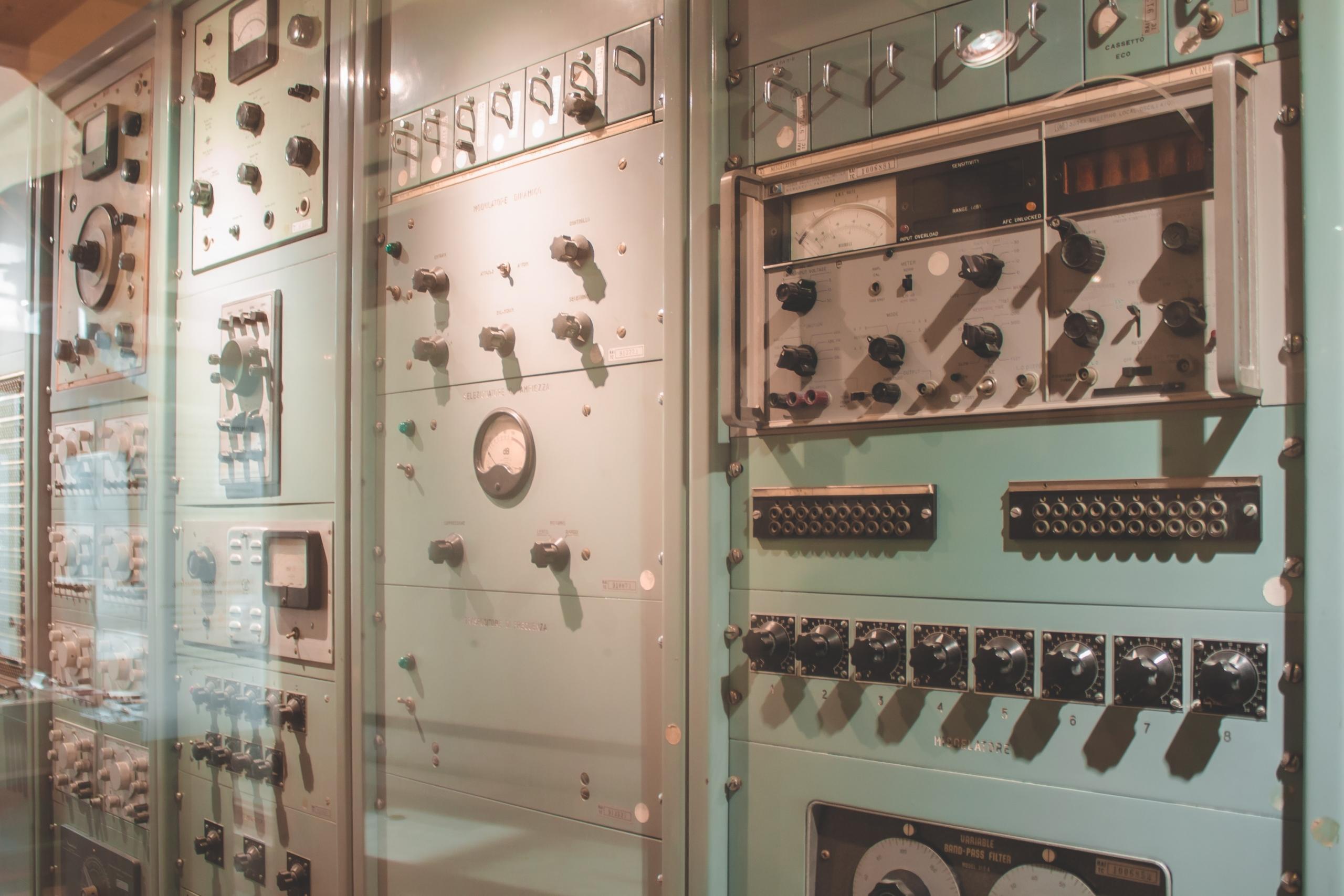

Pero tal vez Turing es más conocido por descifrar Enigma. Nos traslademos a 1943, en plena Segunda Guerra Mundial. Los nazis se comunicaban entre sí gracias a la máquina de encriptación Enigma, que era como una simple máquina de escribir con un mecanismo de rotores que permitían mezclar las letras para transmitir un mensaje sin que nadie pudiera descifrarlo. Cuando se recibía el mensaje, un dispositivo idéntico procesaba el texto, los rotores giraban en sentido contrario y, como en un espejo, el mensaje se veía claramente.

Los Aliados tenían en su poder a una Enigma, pero no sabían como funcionaba, y descifrar el código que encriptaba los mensajes les llevaba demasiado tiempo, mientras que los nazis lo cambiaban diariamente. Este fue el problema que Turing, y el equipo de Bletchley Park, debieron resolver. Si querés conocer más sobre estos acontecimientos, te aconsejamos que veas la película The Imitation Game (o El Código Enigma en español).

Continuemos con la historia de la informática. En 1944, el físico teórico John von Neumann junto a su equipo desarrollan la primera arquitectura de "von Neumann" que sigue siendo la utilizada en la gran mayoría de las computadoras actuales. Técnicamente, toda computadora es una máquina de von Neumann.

Otra mujer excepcional que contribuyó al crecimiento de la disciplina fue Grace Hopper, quien trabajó en la primera computadora digital totalmente automática de IBM: el Harvard Mark I.

Una anécdota sobre el Mark I en 1947: un día se rompió porque una mariposa quedó atrapada en el circuito. La extrajeron con cuidado, y registraron el incidente con la siguiente frase: First actual case of bug being found o "Primer caso real de un insecto encontrado". Es más, de ahí viene la expresión bug informático como un problema.

Estas primeras computadoras no se podían usar a gran escala, sino solo para un uso muy específico. Grace Hopper defendió la idea de que debía poder escribirse un lenguaje informático, ya que el lenguaje matemático que se utilizaba en esos tiempos no era accesible para todas las personas. Hopper creía que la computadora debía ser capaz de entender el inglés y traducirla a lenguaje máquina. Por ello creó un compilador, un software que puede traducir los elementos de un algoritmo en lenguaje máquina y, por lo tanto, ser comprensible para todos los ingenieros.

(Si, es un tanto más complejo que crearse una cuenta de Facebook, pero si no sabés cómo hacerlo, no dudes en entrar en nuestro artículo sobre el tema).

Cuando Grace Hopper murió en 1992, las computadoras llegaron a los hogares de la gente común, ya que se volvieron accesibles para la población general. Con la llegada de internet de mano de Tim Berners-Lee y su equipo, las computadoras ampliaron las comunicaciones a nivel mundial.

Parte 3: De la codificación de la información hasta el objeto digital

La información es un material abstracto que se mide. Un mensaje, sea cual sea su valor real o supuesto, contiene una cantidad precisa de datos. El átomo de un dato es un elemento binario, un bit, como "sí/no", "1/0" o "verdadero/falso". Saber si alguien es un hombre o una mujer, si es joven o viejo, si es alto o bajo, es muy esquemático, pero ya nos da tres átomos de información sobre esa persona con tres bits.

El bit es la unidad mínima de información que utilizan las computadoras para manejar grandes volúmenes de datos. En la tercera etapa de las computadoras, los científicos lograron codificar información no matemática para que todos los objetos (imágenes, sonidos, textos y datos) tengan un reflejo digital que permite procesar la información, transmitirla, reproducirla hasta el infinito y manipularla de manera específica.

Con la llegada de Internet, surgieron nuevos desafíos para los científicos informáticos. Una de las figuras que tenés que conocer entre los nombres de los mejores programadores de la historia es Rose Dieng-Kuntz.

Dieng-Kuntz, científica senegalesa, ayudó a construir la web semántica que designa un conjunto de tecnologías para hacer que la información de la web sea accesible y utilizable por todos los programas de software y por las personas gracias a un sistema de metadatos.

¿Cómo funciona la web semántica? Si escribimos "accidente de tráfico" en un motor de búsqueda, en realidad buscará todos los documentos en los que aparezcan las palabras "accidente" y "tráfico" pero si el documento dice "colisión entre un camión y una bicicleta" sin mencionar concretamente "accidente de tráfico", no debería aparecer. La web semántica busca solucionar ese problema.

Parte 5: La evolución de la interfaz hombre-máquina

A comienzos del siglo XXI, las interfaces entre las computadoras y las personas aún estaban en su etapa inicial. Esto quiere decir que el sistema no era instintivo y en términos generales, poco estético.

En 1968, aprovechando el desarrollo de la televisión en color, Douglas Engelbart presenta un entorno gráfico con ventanas que se pueden abrir y cerrar con un puntero conectado a la computadora, el mouse. ¿Te suena ese modelo de pantalla?

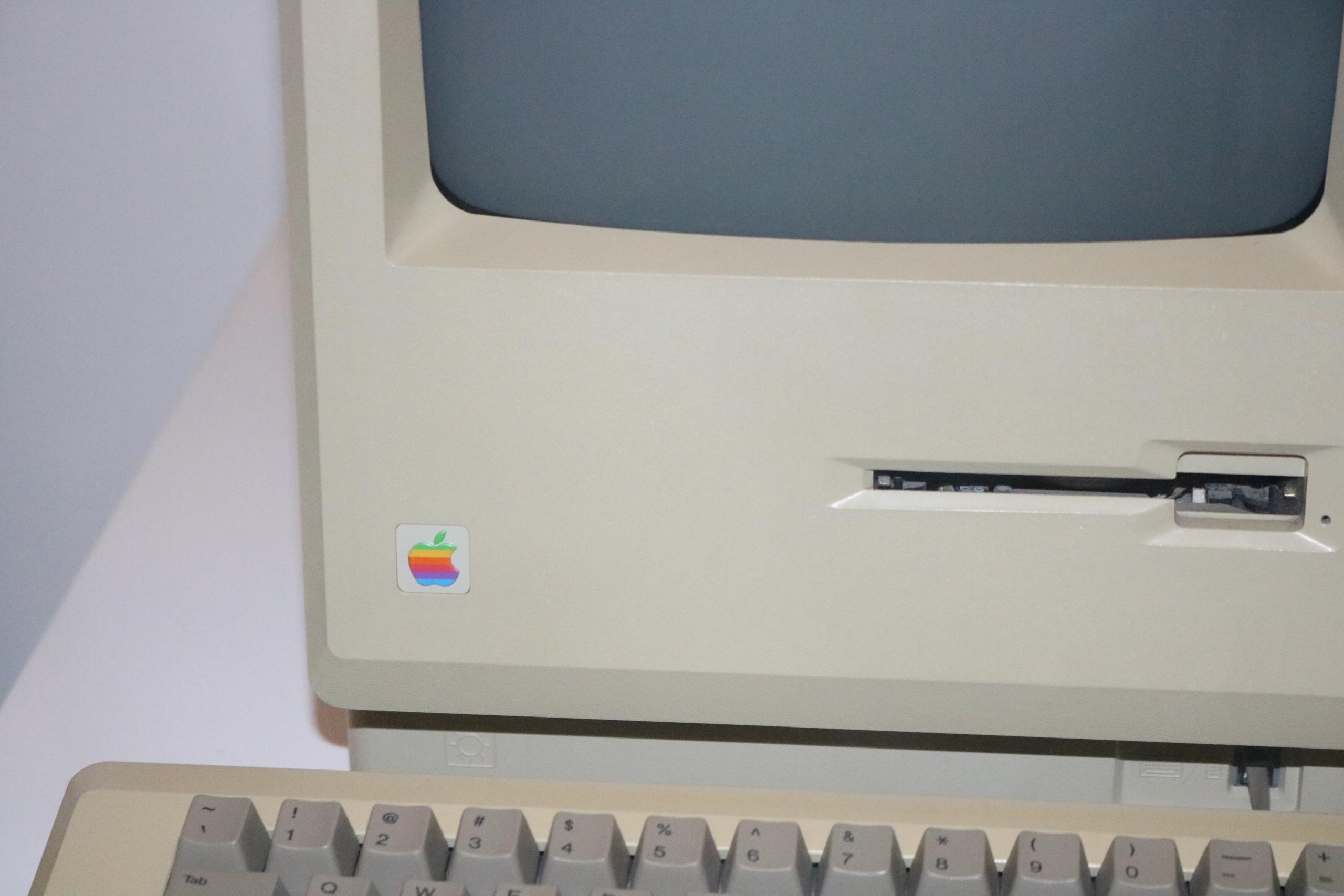

Entre 1984 y la actualidad, muchos inventos se centran en la estética y la comodidad del usuario. Lo que se busca es que las personas comunes (no especialistas) puedan aprovechar la computadora al máximo. El contenido de la pantalla se presenta bajo la forma What You See Is What You Get (WYSIWYG) -en español, "Lo que vés es lo que obtenés"-. Esta expresión fue popularizada por Apple y su famoso Macintosh. La interacción se vuelve simbólica con ventanas, iconos, menús y dispositivos con puntero, y todo el mundo aprende a usarlos. Es el nacimiento de la informática para el público en general.

Además se fueron creando distintos dispositivos para realizar tareas específicas. Estos accesorios de una computadora se vuelven indispensables con el tiempo: como el teclado o la cámara web.

Ya en el s.XXI los avances son cada vez más veloces, con descubrimientos y nuevos productos todos los años. Se mejoraron todas las características de las computadoras e Internet, pero queda mucho por hacer. ¿Qué nuevos inventos encontraremos en el futuro?

Si te interesa saber más sobre la computación actual, te recomendamos comenzar clases de informática con alguno de los profesores en Superprof. Estas clases te servirán tanto si querés ser programador, te entusiasma la historia de la informática o simplemente sentís curiosidad sobre esta fascinante disciplina.

Resumir con IA